实现降维有两种主要方法:特征选择和特征提取。在这里,不用太在意 "特征"一词。在机器学习(主要采用 PCA)中,"特征"一词只是指一种可测量的属性,通常与 "预测因子"一词交替使用。在 Prism 中,你也会看到这些变量被简单地称为变异性。

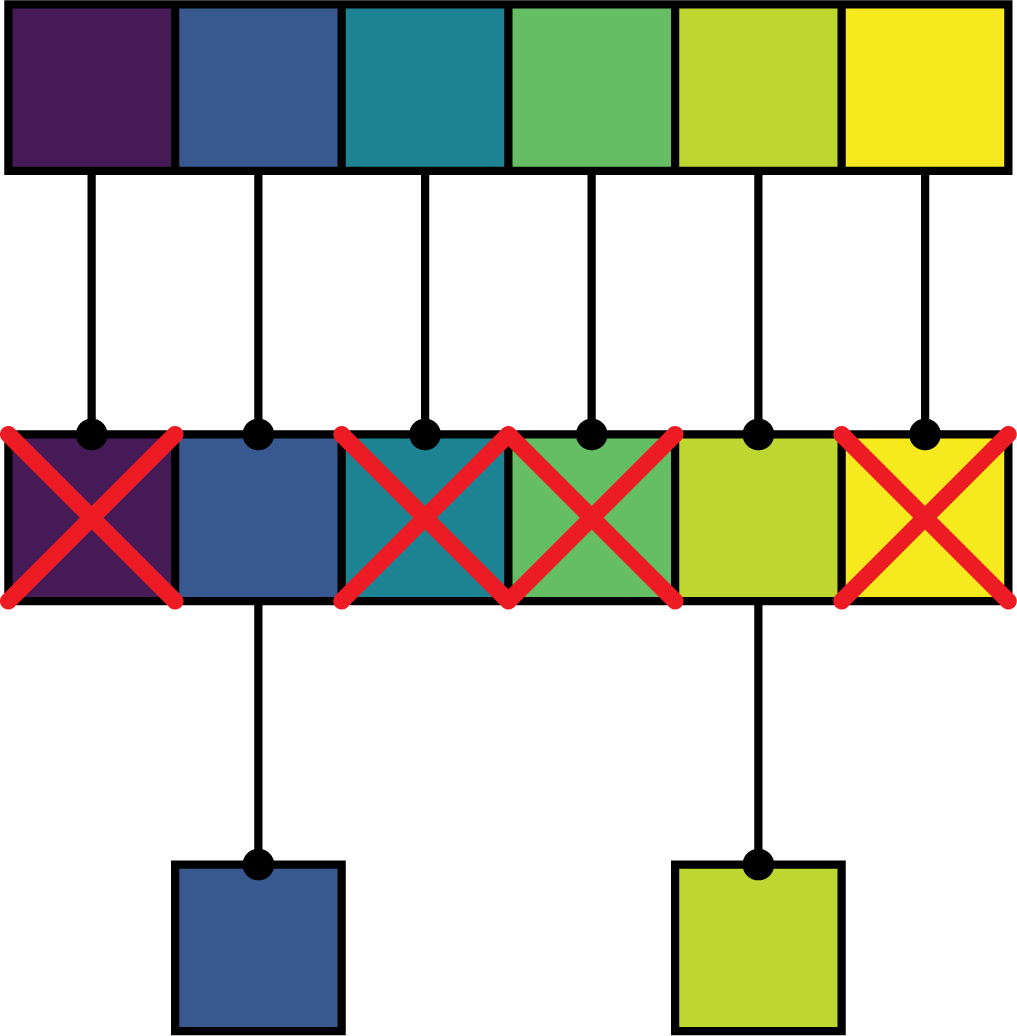

特征选择和特征提取的主要区别在于如何处理数据集中的原始变量。在进行特征选择时,首先要考虑所有变量,然后根据特异性标准剔除一些变量。剩下的变量可能会经过多轮额外的选择,但一旦过程结束,所选变量与原始数据中的变量保持不变。

特征选择只是从原始变量中选择 "最重要 "的变量,而舍弃其他变量。一些经典的特征选择技术(特别是逐步选择、向前选择或向后选择)通常被认为是不明智的,Prism 目前还没有提供任何形式的自动特征选择技术。

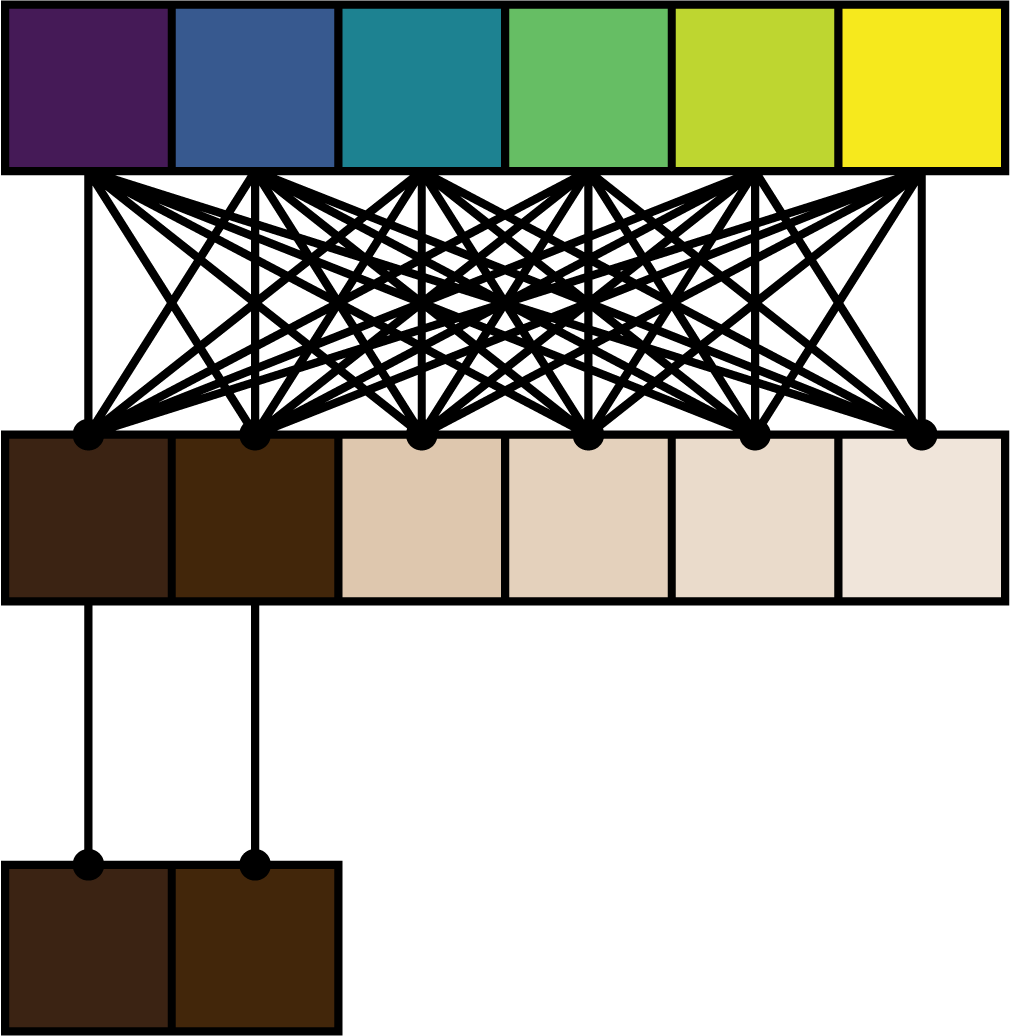

相比之下,特征提取使用原始变量来构建一组新的变量(或特征)。从原始变量中提取这些新特征的方法可以是线性的,也可以是非线性的。PCA 是最常用的线性特征提取方法。在这种方法中,PCA 使用原始变量的线性组合来得出新的特征集(在 PCA 中,我们称这些新特征为主成分,或PC)。

要理解线性组合,请想想下面的水果潘趣酒配方:

果汁

8杯蔓越莓汁

3 杯菠萝汁

3杯橙汁

¼ 杯柠檬汁

4 ¼杯姜汁汽水

另一种方法是用成分(变异性)的线性组合来表示:

果味潘趣酒 = 8*(蔓越莓汁)+ 3*(菠萝汁)+ 3*(橙汁)+ 0.25*(柠檬汁)+ 4.25*(姜汁汽水)

每个变异性乘以一个常数(系数),然后将乘积相加。PCA 通过生成原始变量线性组合的 PC 来执行类似的过程。PCA 真正重要的部分在于这些 PC 的定义方式,它可以将原始数据投射到一个更低维度的空间,同时最大限度地减少信息丢失。

下面两张图片概括了特征选择(消除原始变量)和特征提取(形成作为原始变量组合的新变量)之间的差异,然后使用包含最有用信息的新变量投影到低维空间。